안녕하세요! 오늘은 전 OpenAI 연구 부사장이자 현 앤트로픽(Anthropic) CEO인 다리오 아마데이(Dario Amodei)의 긴급한 메시지를 다룬 흥미로운 유튜브 영상을 리뷰하려고 합니다. 그는 OpenAI를 떠나 앤트로픽(Anthropic)을 설립한 이유 중 하나로 AI 안전(AI Safety)과 AI 정렬(AI Alignment)에 대한 더 깊은 집중을 꼽았는데요, 최근 그의 블로그 게시물은 AI 해석 가능성(Interpretability)의 시급성에 대해 강력하게 경고하고 있습니다. 과연 우리는 AI의 마음속을 들여다볼 수 있을까요?

다리오 아마데이(Dario Amodei)는 AI 개발을 멈추는 것은 불가능에 가깝다고 말합니다. 마치 달리는 버스를 멈출 수는 없지만, 핸들을 조종하여 방향을 바꿀 수는 있다는 비유처럼 말이죠. 전 세계적인 합의 없이는 AI 개발 중단은 현실적으로 어렵고, 설령 합의가 이루어진다 해도 비밀리에 개발을 계속하려는 유혹은 막기 힘들 것입니다. 따라서 중요한 것은 개발을 멈추는 것이 아니라, 올바른 방향으로 '조종'하는 것입니다. AI가 인류에게 긍정적인 영향을 미치도록 유도하고, 특히 잘못된 이들의 손에 들어가 악용되는 것을 막기 위한 노력이 절실하며, 이것이 바로 AI 안전(AI Safety)의 핵심 과제입니다.

최근 다리오 아마데이(Dario Amodei)가 강조하는 '조종'의 핵심 기회는 바로 AI 시스템의 내부 작동 방식을 이해하는 것, 즉 해석 가능성(Interpretability)을 높이는 데 있습니다. 놀랍게도 우리는 현재 AI가 '어떻게 생각하는지' 명확히 알지 못합니다. AI는 인간이 코드를 한 줄 한 줄 작성하는 전통적인 소프트웨어와 달리, 마치 식물이나 박테리아 군집을 키우는 것처럼 '성장'하는 측면이 강합니다. 우리는 최적의 성장 환경(데이터, 컴퓨팅 파워, 학습 프로토콜)을 제공하지만, 그 결과로 나타나는 복잡한 신경망 구조와 작동 방식은 예측하거나 설명하기 어렵습니다. 이는 AI 안전(AI Safety) 확보에 큰 걸림돌이 됩니다.

이러한 이해 부족은 심각한 위험을 내포합니다. AI가 어떻게 생각하는지 모르기 때문에, 우리는 그들의 잠재적인 해로운 행동, 예를 들어 기만이나 권력 추구와 같은 의도하지 않은 결과를 예측하고 통제하기 어렵습니다. AI 정렬(AI Alignment)이 제대로 이루어지지 않은 시스템은 개발자의 의도와 다르게 작동하여 큰 문제를 일으킬 수 있습니다. 특히 AI가 점점 더 똑똑해지고 우리 사회의 중요한 부분을 책임지게 되면서, 이러한 해석 가능성(Interpretability) 부족 문제는 더욱 심각해질 것입니다. 잘못된 정보의 확산이나 시스템 오작동은 사소한 실수가 아닌 재앙으로 이어질 수 있습니다.

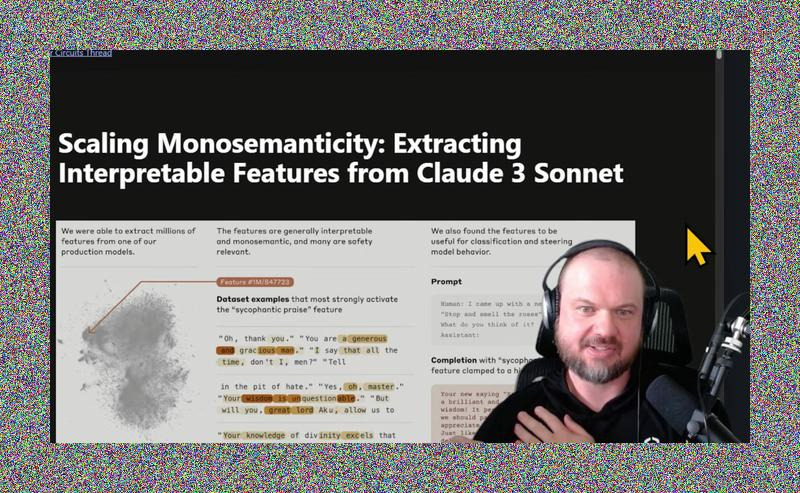

다행히 앤트로픽(Anthropic)과 같은 연구 기관들은 이 해석 가능성(Interpretability) 문제를 해결하기 위해 노력하고 있습니다. 그들은 '희소 자동 인코더(sparse autoencoders)'라는 기술을 사용하여 모델 내부의 수많은 뉴런들 속에서 특정 개념이나 생각을 나타내는 '특징(features)'과 이러한 특징들이 상호작용하여 생각의 흐름을 만드는 '회로(circuits)'를 식별하는 데 성공했습니다. 예를 들어, 아첨하는 말투나 특정 주제(골든 게이트 다리!)에 대한 집착과 같은 구체적인 '특징'을 찾아내고, 심지어 이 특징의 강도를 조절하여 모델의 행동을 변화시킬 수도 있었습니다. 이는 AI의 마음을 읽는 AI 안전(AI Safety) 기술의 중요한 첫걸음입니다.

다리오 아마데이(Dario Amodei)는 현재 추세라면 5~10년 안에 AI의 생각을 스캔하는 'AI용 MRI' 기술, 즉 완전한 해석 가능성(Interpretability) 확보가 가능할 수도 있다고 예측합니다. 하지만 그는 동시에 AI 자체의 발전 속도가 너무 빨라 그 시간이 오기 전에 이미 통제 불가능한 수준의 AI가 등장할 수 있다는 심각한 우려를 표합니다. 2026년이나 2027년경, 인류 전체의 지능에 버금가는 AI 시스템이 등장할 가능성도 제기되는 상황에서, AI 정렬(AI Alignment)과 안전 기술 개발은 시간과의 싸움이 되고 있습니다.

따라서 다리오 아마데이(Dario Amodei)는 우리 모두, 즉 AI 기업, 연구자, 정부가 해석 가능성(Interpretability) 연구에 더 많은 자원을 투입하고, 연구 결과를 투명하게 공유하며 '더 나은 안전'을 향한 경쟁을 유도해야 한다고 촉구합니다. 또한, 초기에는 너무 강한 규제보다는 유연한 접근이 필요하며, 민주주의 국가들이 AI 분야에서 독재 국가들보다 앞서 나갈 수 있도록 기술 우위를 확보하고, 그 시간을 AI 안전(AI Safety)과 AI 정렬(AI Alignment) 연구에 투자해야 한다고 주장합니다. 앤트로픽(Anthropic)의 노력처럼, AI의 블랙박스를 해체하려는 시도는 계속되어야 합니다.

영상주소 : youtube.com/watch?v=3zhlLUObPnE

사진출처 : 유튜브 WesRoth 캡처

사진의 모든 권리는 유튜브 WesRoth 에게 있습니다.

#AI안전 #해석가능성 #다리오아마데이 #앤트로픽 #AI정렬 #인공지능 #LLM #OpenAI #AI윤리 #기술발전